alpi

human being

- Регистрация

- 29 Июл 2014

- Сообщения

- 260

- Реакции

- 306

- Автор темы

- #1

Хочу поделиться найденным решением по оптимизации картинок для гугла.

Утилита от гугла Для просмотра ссылки Войдиили Зарегистрируйся

Цель - поднять гугл-попугаев на странице каталога. Сопутствующий мелкий бонус - ускорить загрузку сайта за счет экономии трафика, мобильные клиенты скажут вам спасибо.

Инструкция для линукса.

вводим несколько заклинаний:

И оставляем сервер в покое/продолжаем работать - процесс висит в фоне и обрабатывает все картинки, которые выводит преста на странице каталога.

Утилита далеко не быстрая (потому и обрабатываю только один тип картинок, а не все), заявленная скорость около 1Мб в минуту. к счастью, сгенерированные престой имеджи уже небольшие по размеру.

У меня, на очень быстрой впс с выделенным ссд(все иопс мои) и хорошим процом обрабатывает около 1000 файлов в час (при этом одно из ядер загружено на 100%). На недорогих vps скорее всего будет медленнее, расчитывайте на сутки и более, если товаров много.

проверить, сколько файлов осталось обработать можно так:

*home_default.jpg - шаблон актуален для вархаус.

ремарка - во избежание артефактов, не рекомендуется применять для уже пережатых изображений, лучшим вариантом будет в престе перегенерить из исходников картинки с максимальным качеством, а потом прогнать этой утилитой. ну то таке, я не заморачивался.

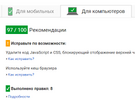

итог: 89 попугаев вместо 83 в гугле, и экономия около 75кб трафика.

удачи

p.s.

после полного прогона хорошо бы автоматом пережимать новые картинки. для этого в крон нужно закинуть вот это:

проверять раз в сутки

Утилита от гугла Для просмотра ссылки Войди

Цель - поднять гугл-попугаев на странице каталога. Сопутствующий мелкий бонус - ускорить загрузку сайта за счет экономии трафика, мобильные клиенты скажут вам спасибо.

Инструкция для линукса.

вводим несколько заклинаний:

Код:

cd /home/user

wget https://github.com/google/guetzli/releases/download/v1.0.1/guetzli_linux_x86-64

chmod +x /home/user/guetzli_linux_x86-64

nohup find /var/www/presta/img/p/ -type f -name "*home_default.jpg" -exec /home/user/guetzli_linux_x86-64 --quality 90 '{}' '{}' ';' &Утилита далеко не быстрая (потому и обрабатываю только один тип картинок, а не все), заявленная скорость около 1Мб в минуту. к счастью, сгенерированные престой имеджи уже небольшие по размеру.

У меня, на очень быстрой впс с выделенным ссд(все иопс мои) и хорошим процом обрабатывает около 1000 файлов в час (при этом одно из ядер загружено на 100%). На недорогих vps скорее всего будет медленнее, расчитывайте на сутки и более, если товаров много.

проверить, сколько файлов осталось обработать можно так:

Код:

find /var/www/presta/img/p/ -type f -mtime +1 -name "*home_default.jpg" | wc -l*home_default.jpg - шаблон актуален для вархаус.

ремарка - во избежание артефактов, не рекомендуется применять для уже пережатых изображений, лучшим вариантом будет в престе перегенерить из исходников картинки с максимальным качеством, а потом прогнать этой утилитой. ну то таке, я не заморачивался.

итог: 89 попугаев вместо 83 в гугле, и экономия около 75кб трафика.

удачи

p.s.

после полного прогона хорошо бы автоматом пережимать новые картинки. для этого в крон нужно закинуть вот это:

Код:

find /var/www/presta/img/p/ -type f -name "*home_default.jpg" -mtime -1 -exec /home/user/guetzli_linux_x86-64 --quality 90 '{}' '{}' ';'

Последнее редактирование: